Вопрос или проблема

В настоящее время я провожу исследование методов, которые решают проблемы классификации намерений и заполнения слотов в NLP. Одним из подходов, с которым я решил начать эксперименты, предложен в следующей статье:

https://arxiv.org/abs/1609.01454

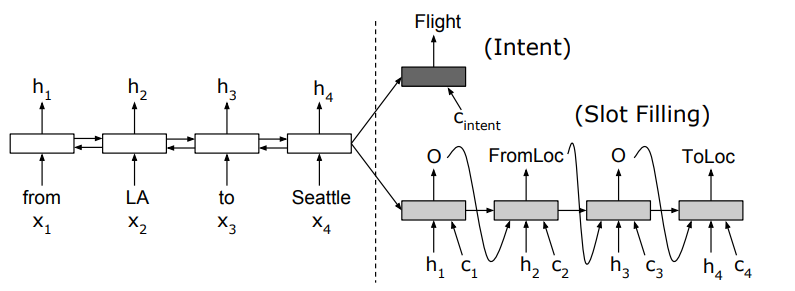

В этой статье сеть обучается совместно для обеих задач. Архитектура кодировщика-декодировщика представлена ниже:

Кодировщик – это двунаправленная LSTM, а декодер – это другая LSTM. Благодаря совместному обучению обеих задач имеется один декодер для классификации намерений и другой декодер для предсказания меток слотов. На каждом этапе в фазе декодирования блок получает предыдущее скрытое состояние, предыдущий сгенерированный токен (или корректный токен во время обучения) и контекстный вектор от операции внимания со всеми скрытыми состояниями кодировщика. Также есть несколько моментов, которые стоит отметить для реализации:

Последнее скрытое состояние обратной LSTM в кодировщике используется в качестве первоначального контекста для декодера (также как последнее состояние ячейки), в соответствии с статьей “Нейронный машинный перевод с совместным обучением выравнивать и переводить”.

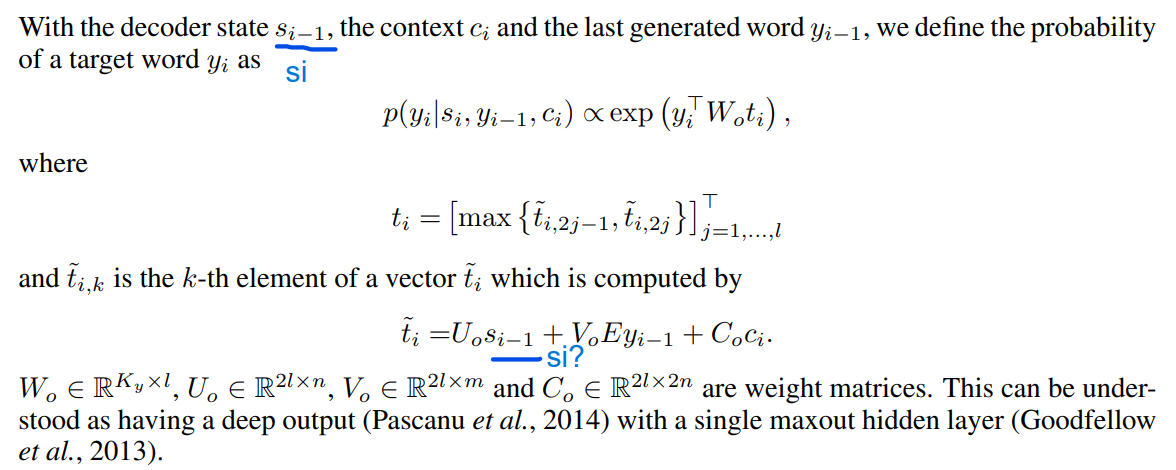

Для выходного слоя текущее скрытое состояние, состояние ячейки (контекст) и предыдущий выходной токен все линейно проецируются и берутся с максимальным значением, прежде чем снова проецироваться для получения вероятностных классов меток слотов, как упомянуто в вышеуказанной статье.

Что касается реализации этой статьи, среди доступных реализаций на GitHub я нашел следующую с наибольшим количеством звезд:

https://github.com/DSKSD/RNN-for-Joint-NLU/tree/master

Тем не менее, я думаю, что в репозитории есть проблемы с механизмом внимания и инициализацией для декодера и весов всей сети. Таким образом, я временно доработал репозиторий в следующем блокноте:

https://www.kaggle.com/code/minhtucanh/rnn4jointnlu

Хотя этот блокнот еще не совсем организован, я внес некоторые изменения в Кодировщик, Декодер и процедуру обучения.

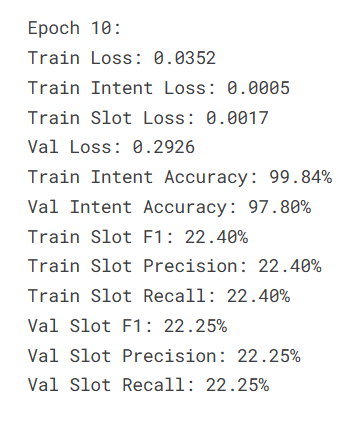

Однако, как вы можете видеть, хотя производительность классификации намерений значительно улучшается, F1 для заполнения слотов остается прежним на протяжении обучения и оценки (несмотря на использование teacher forcing).

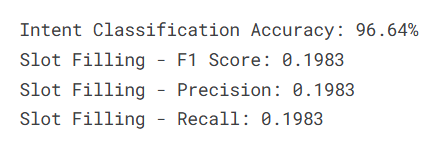

Результаты тестирования плохие:

Я смотрел на это некоторое время, но все еще не понимаю. Я не уверен, что делать дальше, чтобы понять, в чем проблема. Я был бы благодарен за любую помощь или комментарии по этому поводу!

Спасибо.

Ответ или решение

Проблемы с эффективностью архитектуры энкодера-декодера на основе внимания для извлечения слотов могут быть вызваны несколькими факторами. В данном контексте рассмотрим ключевые аспекты, которые следует проанализировать для понимания причин низкой производительности и поиска путей её улучшения.

1. Подбор архитектуры

Структура сети

Архитектура, в которой используется двойной декодер, может привести к снижению производительности в задачах извлечения слотов. Параллельное обучение двух разных задач (классификация намерений и извлечение слотов) может затруднить оптимизацию модели, особенно если одна из задач доминирует над другой в момент обучения. Рекомендуется проанализировать, как балансируется обучение, и возможно, использовать взвешивание потерь для обеих задач, чтобы предотвратить преобладание одной над другой.

2. Механизм внимания

Инициализация и механика

Ошибки в реализации механизма внимания могут значительно повлиять на качество извлечения слотов. Убедитесь, что:

- Контекстный вектор корректно вычисляется на основе всех состояний энкодера.

- Механизм внимания адаптируется к специфике каждого из декодеров (для намерений и для слотов).

- Проверьте, не мешают ли агрегация информации и нормализация на этапе получения контекстного вектора правильной интерпретации входных данных.

3. Инициализация весов и настройка гиперпараметров

Подбор гиперпараметров

Инициализация весов также играет важную роль в производительности модели. Рекомендуется:

- Использовать более специализированные методы инициализации (например, He или Glorot), которые могут дать модели более стабильное начало.

- Экспериментировать с разными значениями скорости обучения, размерами батча, а также количеством эпох обучения и схемами регуляризации, такими как Dropout.

4. Обработка входных данных

Предварительная обработка

Качество входных данных имеет критическое значение для всех задач в NLP. Убедитесь, что:

- Данные для обучения и тестирования очищены и правильно размечены.

- Применяются соответствующие техники предобработки, такие как лемматизация или стемминг, которые могут помочь в более точной классификации слотов.

5. Учебный процесс

Техники обучения

Процесс обучения важен для общего успеха модели. Учёт следующих аспектов может быть полезен:

- Использование метода "teacher forcing" может не всегда давать желаемые результаты, так как он может мешать модели в обучении воспроизводить свою собственную генерацию в будущем.

- Попробуйте различные подходы к обучению, такие как кросс-валидация, чтобы оценить стабильность производительности модели на различных поднаборах данных.

6. Оценка модели

Метрики и анализ

Несмотря на достижения в классификации намерений, низкие показатели F1 для извлечения слотов подразумевают наличие проблемы. Проанализируйте:

- Результаты по классам объектов (слотов) — возможно, некоторые классы имеют слишком мало примеров и, следовательно, получают менее качественные представления.

- Используйте более детализированные метрики для оценки производительности (например, precision, recall) вместо единичного значения F1 для более полной картины.

Заключение

Обратите внимание на все вышеперечисленные аспекты, проверяя и тестируя каждую потенциальную причину на практике. Это может помочь не только выявить проблемы, но и существенно улучшить результаты извлечения слотов. Рассмотрите возможность рефакторинга модели, уделяя внимание специфическим аспектам, позволяющим решать две задачи параллельно с учетом их взаимосвязи. Постепенные изменения с систематической проверкой их эффектов помогут наладить качественное обучение и улучшить результаты.