Вопрос или проблема

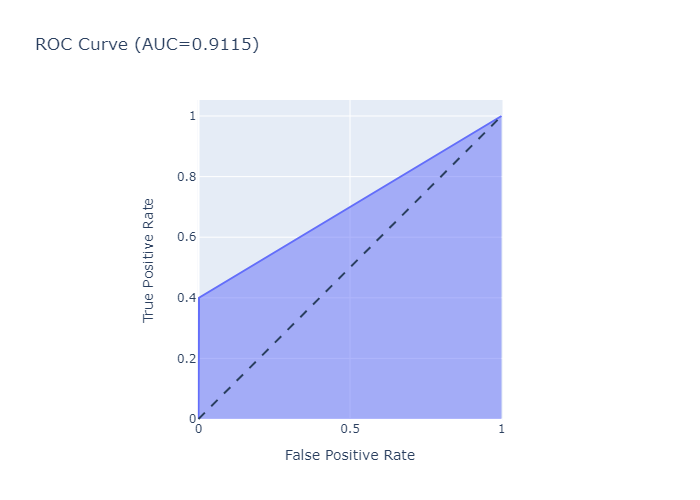

Я работаю над задачей бинарной классификации. Я попытался оценить модель, построив ROC-кривую и рассчитав ROC AUC. Рассчитанный балл составляет 0.9115, но площадь кривой выглядит нереалистично для этого балла. Я попытался грубо рассчитать площадь, разделив её на прямоугольник и треугольник, а затем сложив площади этих фигур, но это дало мне около 0.7 (я не уверен, правильно ли я рассчитал площадь). Есть идеи?

Основываясь на комментарии @Dave, я нашел проблему. ROC-кривая была построена, используя фактические предсказания классов, тогда как должны были быть использованы вероятности предсказаний, которые можно рассчитать с помощью метода predict_proba. Изменение этого дало правильный график.

Ответ или решение

Вопрос, связанный с корректностью ROC-кривой и вычислением AUC (площади под кривой), всплывает довольно часто в процессе оценки бинарных классификаторов. Рассмотрим подробнее проблему, с которой вы столкнулись.

Анализ несоответствия между ROC-кривой и AUC

-

Основные понятия:

- ROC-кривая (Receiver Operating Characteristic) — график, показывающий соотношение между истинными положительными результатами (True Positive Rate, TPR) и ложными положительными результатами (False Positive Rate, FPR) при различных порогах классификации.

- AUC (Area Under the Curve) — площадь под ROC-кривой; стойкий показатель, который позволяет quantitatively оценивать эффективность модели. Значение AUC варьируется между 0 и 1, где 1 соответствует идеальной классификации, а 0.5 указывает на отсутствие отличия между классами.

-

Проблема с начальным расчетом:

- Вы указали, что ваш AUC равен 0.9115, в то время как визуально оцененный вами результат около 0.7. Такая разница может возникнуть при использовании неверных входных данных для построения ROC-кривой.

- Одной из наиболее распространенных ошибок является использование классовых предсказаний (например, 0 и 1) вместо вероятностей, полученных с помощью метода

predict_proba. Это может привести к искажению результатов, так как ROC-кривая не сможет адекватно реагировать на различные пороги.

-

Исправление ошибки:

- Очень важно для оценивания качества модели строить ROC-кривую на основе вероятностных предсказаний. Использование метода

predict_probaпозволяет получить более надежные результаты для построения ROC-кривой, корректируя тем самым оценку AUC. - Как вы правильно заметили в вашем последующем комментарии, после замены предсказаний на вероятностные значения вы получили корректные результаты. Это является подтверждением того, что начальный расчет осуществлялся неверно.

- Очень важно для оценивания качества модели строить ROC-кривую на основе вероятностных предсказаний. Использование метода

Рекомендации для дальнейшей работы

-

Повторная проверка: Всегда проверяйте метод, который вы используете для вычисления AUC и построения кривой. Убедитесь, что вы работаете с вероятностями, а не с бинарными метками.

-

Визуализация данных: Для более точной интерпретации результатов может быть полезным использование других методов визуализации, таких как Precision-Recall кривые, которые могут дополнить понимание работы модели.

-

Кросс-валидация: Рассмотрите использование кросс-валидации для уменьшения смещения и повышения надежности вашей модели.

Заключение

Ошибки в построении ROC-кривой и вычислении AUC могут значительно искажать восприятие качества модели. Правильное использование методов предсказания и соответствующих концепций позволяет получить точные и достоверные результаты. Удачи в дальнейших экспериментах с вашей моделью, и не забывайте обращать внимание на детали, так как даже небольшие изменения могут привести к существенным изменениям в интерпретации результатов.